Principal Component Analysis(主成分分析)、Canonical Correspondence Analysis(典型相关分析)、Partial Least Square(偏最小二乘)

从多元线性回归说起

•目的:p个自变量x 对1个因变量y的回归

•回归方程为:

•手上有n个观测(相当于训练集),用这n个观测来估计β

根据最小二乘法:

一个小问题:若Y也有多个变量时怎么办?假如Y有q个变量,给Y添加一个长度为q的维度就可以了,回归公式仍然成立。

•但多元线性回归存在缺陷:

1.理论假设需要满足自变量x1, x2 ··· xp互相独立(现实中往往具有多重共线性);

2.当X的变量数非常多时,求解β时需要求$(X^TX)^{-1}$,这是一个p*p的高维方阵,求解困难;

3.而且不一定每个x因子都是显著的,包含冗余信息。

PCA(主成分分析)

•目的:提取变量中最能代表其特征的成分

•变量X(已标准化)

有n个观测时X就是n*p的矩阵

•记u是X的一个主成分,a为载荷向量

•要求是a使得u的方差最大(其实就是最小二乘),即令

最大

「为什么要令u的方差最大呢?」下面以简单的X有两个变量的例子说明:

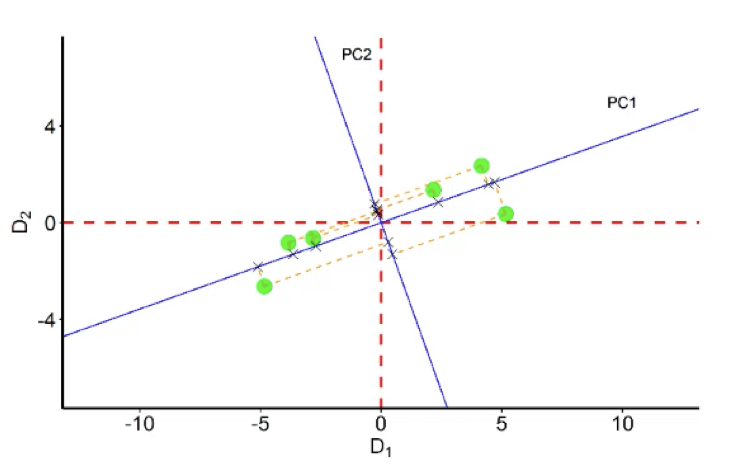

Var(u)的几何意义其实是X在主成分载荷向量a上投影点到原点距离平方和,可以从两个角度来理解这个问题。

令Var(u)尽量大,也就是该主成分载荷向量(PC1蓝线)可以把X的样本点分得尽量开,更能反映样本的差异(差异其实就是特征);另外,这其实也是最小二乘思想,令Var(u)最大,就是令各样本点到PC1的距离平方和最小(想想看,各样本点到原点的距离是固定的)。

•求主成分的问题就可以提炼为

最终转化为熟悉的求特征值和特征向量问题,保留k个主成分原来p维的X就降维到了k维。

CCA(典型相关分析)

•目的:提取出因变量和自变量中最相关的成分

•因变量Y和自变量X(都已标准化)

•记典型变量u,v,分别是X各变量和Y各变量的线性组合

•要使得u,v相关性最大,即令相关系数

最大

•求典型相关变量的问题就提炼为

同样最后转化为求特征值和特征向量的问题。

PLSR(偏最小二乘回归)

•目的:用自变量中与因变量最相关的“典型变量”做回归

•因变量Y和自变量X(都已标准化)

•记典型变量u,v,分别是X各变量和Y各变量的线性组合

•要求

- u,v的方差最大(PCA思想)

- 使得u,v相关性最大(CCA思想)

•问题提炼为

PLS是PCA和CCA的结合的说法是网上看到的(老师也这么讲)。但有个问题是:既然给定了样本,X和Y的协方差矩阵相当于就是固定的,那最后这个求解模型的约束条件不就和CCA是一样的?事实上就是求了个典型相关变量?•得到了“典型变量”之后,建立Y对u1的回归,X对u1的回归

•用余项($\beta_1u_1$和$\alpha_1u_1$解释后的残余信息)再建立对u2的回归

•如此重复只要达到满意的精度就可以停止,得到

•代入u的定义式

就可以得到最终的偏最小二乘回归方程

参考

StatQuest with Josh Starmer @YouTube